Vor Zurück Inhalt

5. Elektronische Gehilfen

Es existieren eine Vielfalt von Modellen, in denen Computer eingesetzt worden sind, um Emotionen zu erkennen bzw. Emotionen darzustellen. Diese Modelle sind nicht im eigentlichen Sinne "emotionale Computer", da es sich bei ihren "emotionalen" Komponenten um vordefinierte Elemente handelt und nicht um ein Subsystem, das sich selbständig entwickelt hat.

Die im folgenden beschrieben Modelle sind zum großen Teil regelbasierte Produktionssysteme (rule-based production systems). Damit sind sie zugleich auch symbolverarbeitende Systeme. Seit den sechziger Jahren bis heute gibt es eine rege Diskussion darüber, ob bzw. in welchem Umfang der menschliche Geist ein symbolverarbeitendes System darstellt und inwieweit symbolverarbeitende Computermodelle insofern eine realistische Annäherung an reale Funktionsweisen sein können (siehe dazu z.B. Franklin, 1995).

Ein regelbasiertes Produktionssystem verfügt als Mindestausstattung über eine Reihe von Standardkomponenten:

-

eine sogenannte knowledge base, die die Verarbeitungsregeln des Systems enthält;

-

eine sogenannte global database, die den Arbeitsspeicher des Systems darstellt;

-

eine sogenannte control structure, die den Inhalt der global database analysiert und entscheidet, welche Verarbeitungsregeln der knowledge base Anwendung finden.

Eine detailliertere Darstellung eines regelbasierten Produktionssystems liefert Franklin (1995) am Beispiel von SOAR: Das System operiert innerhalb eines definierten problem space; der Produktionsprozess des Systems ist die Anwendung von entsprechenden condition-action rules, die den problem space von einem Zustand in einen anderen transformieren.

Als regelbasierte Produktionssysteme können die im folgenden vorgestellten Modelle von Dyer, Pfeifer, Bates und Reilly sowie Elliott betrachtet werden. Das Modell von Scherer bricht insofern etwas aus, als es sich dabei um eine Implementation handelt, die nicht regelbasiert arbeitet. Sein zugrundeliegender Ansatz ist aber eine Einschätzungstheorie und ließe sich ohne weiteres auch als Produktionssystem implementieren.

5.1. Die Modelle von Dyer

Dyer hat im Laufe der Jahre insgesamt drei Modelle entwickelt: BORIS, OpEd und DAYDREAMER. BORIS und OpEd sind dabei Systeme, die Emotionen aus Texten inferieren können; DAYDREAMER ist ein Computermodell, das Emotionen generieren kann.

Dyer betrachtet Emotionen als ein emergentes Phänomen:

Diese "generellen kognitiven Prozesse" sind bei Dyer in Form von demons realisiert, spezialisierten Programm-Subroutinen, die unter bestimmten Bedingungen aktiviert werden und unabhängig voneinander spezifische Aufgaben durchführen. Nach der Erledigung ihrer Arbeit "sterben" diese demons ab oder rufen neue Subroutinen ins Leben.

5.1.1. BORIS

BORIS basiert auf einem sogenannten affect lexicon, das sechs Komponenten besitzt: Eine Person, die die Emotion empfindet; die Polarität der Emotion (positiv - negativ); eine oder mehrere Zielerreichungssituationen; den Gegenstand oder die Person, auf die die Emotion sich richtet; die Stärke der Emotion sowie die jeweilige Erwartungshaltung.

Mit diesen Komponenten stellen sich in BORIS Emotionen wie folgt dar:

Emotion: Erleichterung

Person: x

Polarität: positiv

gerichtet auf: -/-

Zielerreichung: Ziel erreicht

Erwartung: Erwartung nicht erfüllt

In diesem Fall hat die Person x nicht erwartet, daß sie ihr Ziel erreichen wird. Diese Erwartung hat sich nicht erfüllt. Jetzt erlebt die Person x einen positiven Erregungszustand, den sie als Erleichterung empfindet (nach Dyer, 1987, S. 325).

In ähnlicher Form sind in BORIS Emotionen wie happy, sad, grateful, angry-at, hopeful, fearful, disappointed, guilty usw. repräsentiert.

Das unterstreicht den Anspruch, den Dyer mit BORIS verfolgt: Alle Emotionen können in BORIS in Form eines negativen oder positiven Erregungszustands, verbunden mit Informationen über die Ziele und Erwartungen einer Person, dargestellt werden.

Dyer weist darauf hin, daß sich mit Hilfe der von ihm genannten Variablen auch Emotionen darstellen lassen, für die es kein entsprechendes Wort in einer bestimmten Sprache gibt.

Mit Hilfe dieses Modells kann BORIS Schlußfolgerungen ziehen auf die jeweilige Zielerreichungssituation einer Person; Text verstehen und generieren, der Beschreibungen von Emotionen enthält sowie die Bedeutungen von emotionalen Begriffen erschließen und vergleichen. Das System ist dabei auch in der Lage, multiple emotionale Zustände zu repräsentieren.

Aus der vorgenommenen Ziel/Plan-Analyse einer Person und dem resultierenden Ergebnis kann BORIS zudem Erwartungen entwickeln, wie sich diese Person weiter verhalten wird, um ihre Ziele zu erreichen. Auch die Stärke eines Erregungszustandes kann von BORIS für solche Vorhersagen genutzt werden.

5.1.2. OpEd

OpEd stellt eine Erweiterung von BORIS dar. Während BORIS aufgrund seines internen Lexikons nur Emotionen in erzählerischen Texten verstehen kann, ist OpEd dazu in der Lage, Emotionen und Überzeugungen auch aus nicht narrativen Texten zu erschließen:

Überzeugungen (beliefs) werden bei OpEd anhand von vier Dimensionen implementiert: Believer ist derjenige, der eine bestimmte Überzeugung besitzt; content ist eine Bewertung von Zielen und Plänen; attack sind die Überzeugungen, welche der aktuell ausgedrückten entgegenstehen; support sind die Überzeugungen, welche die aktuelle Überzeugung unterstützen.

Laut Dyer waren die beliefs ein wesentliches Element, das bei BORIS fehlte. So ist die Aussage "happy(x)" in BORIS repräsentiert als die Erreichung eines Ziels durch x. Das reicht, so Dyer, nicht aus:

Deshalb kommen in OpEd zu den aus BORIS bekannten demons neue hinzu: belief-building, affect-related demons.

Dyer hat gezeigt, daß OpEd dazu in der Lage ist, aus Zeitungstexten nicht nur die Überzeugungen des Autors zu erschließen, sondern auch Schlußfolgerungen über die Überzeugungen derjenigen zu ziehen, gegen die der Autor Position bezieht.

5.1.3. DAYDREAMER

Während BORIS und OpEd dazu gedacht sind, Emotionen zu verstehen, ist DAYDREAMER (Mueller und Dyer, 1985) der Versuch, ein System zu entwickeln, das Emotionen "empfindet" (feel). Diese Empfindung äußert sich dabei nicht in einem subjektiven Zustand des Systems, sondern darin, daß sein jeweiliger "emotionaler" Zustand sein internes Verhalten bei der Verarbeitung von Informationen beeinflußt.

Mueller und Dyer definieren vier wesentliche Funktionen von Tagträumen: Sie steigern die Effektivität zukünftigen Verhaltens durch die Antizipation möglicher Reaktionen auf erwartete Ereignisse; sie unterstützen das Lernen aus Erfolgen und Fehlern durch das Durchspielen alternativer Handlungsmöglichkeiten; sie unterstützen die Kreativität, weil das imaginäre Durchspielen von Handlungsabläufen zu neuen Lösungen führen kann, und sie unterstützen die Regulierung von Emotionen, indem sie deren empfundene Intensität reduzieren.

Um diese Ziele zu erreichen, ist DAYDREAMER mit folgenden Hauptkomponenten ausgestattet:

-

einem scenario generator, der aus einem planner und sogenannten relaxation rules besteht;

-

einem dynamischen episodischen Speicher, dessen Inhalte vom scenariogenerator verwendet werden;

-

einer Ansammlung persönlicher Ziele (personal goals) und Kontrollzielen (control goals), die den scenario generator lenken;

-

einer Emotionskomponente (emotion component), in der Tagträume durch emotionale Zustände, die durch das Erreichen oder Nichterreichen von Zielen ausgelöst werden, entstehen oder initiiert werden;

-

einem Wissen (domain knowledge) über interpersonelle Beziehungen und Alltagsaktivitäten.

DAYDREAMER verfügt über zwei Funktionsarten, den daydreaming mode und den performance mode. Im daydreaming mode bewegt sich das System kontinuierlich in Tagträumen, bis es unterbrochen wird; im performance mode zeigt das System, was es aus den Tagträumen gelernt hat.

Mueller und Dyer postulieren eine Reihe von Zielen, über die ein System verfügt und die sie Kontrollziele nennen. Diese werden zum Teil durch Emotionen ausgelöst und lösen wiederum Tagträume aus. Die Funktion der Kontrollziele besteht darin, kurzfristig für eine Modifikation emotionaler Zustände zu sorgen und langfristig das Erreichen persönlicher Ziele zu sichern.

Das System verfügt somit über einen Feedback-Mechanismus, bei dem Emotionen Tagträume auslösen und Tagträume diese Emotionen modifizieren und neue Emotionen auslösen, die wiederum neue Tagträume initiieren.

Mueller und Dyer nennen vier Kontrollziele, die beim Tagträumen auftreten:

-

Rationalisierung: Das Ziel, ein Versagen wegzurationalisieren und so einen negativen emotionalen Zustand zu verringern.

-

Rache: Das Ziel, bei einem anderen das Erreichen eines Ziels zu verhindern und damit den eigenen Ärger zu reduzieren.

-

Umkehrung von Erfolg oder Mißerfolg: Das Ziel, sich ein Szenario mit einem entgegengestzten Ausgang vorzustellen, um die Polarität eines emotionalen Zustands umzukehren.

-

Vorbereitung: Das Ziel, hypothetische Episoden zu entwickeln, um die Konsequenzen einer möglichen Handlung durchzuspielen.

Mueller und Dyer beschreiben das Funktionieren von DAYDREAMER an einem Beispiel, in dem DAYDREAMER einen aktiven jungen Mann mit sozialen Zielen darstellt, der eine Schauspielerin getroffen hat, die seine Einladung zu einem Drink abgelehnt hat.

DAYDREAMER generiert daraufhin die folgenden beiden Tagträume:

Der erste Tagtraum ist ein Beispiel für Umkehrung: er tut so, als habe das Rendezvous stattgefunden und entwickelt eine Phantasie über die Konsequenzen. Der Realitätsmonitor meldet, daß ein wichtiges Ziel, nämlich die eigene Karriere, vernachlässigt wird. Das Resultat ist eine Rationalisierung, die den negativen emotionalen Zustand verringert.

Tagtraum 2 wird durch den emotionalen Zustand des Ärgers ausgelöst und verkörpert Rache, um so den negativen Effekt des aktuellen emotionalen Zustands zu verringern.

Sobald ein Kontrollziel aktiviert ist, generiert der scenario generator eine Reihe von Ereignissen, die mit dem Kontrollziel zusammenhängen. Diese Tagträume unterscheiden sich insofern von klassischen Plänen, als sie nicht verbissen auf ein Ziel ausgerichtet sind, sondern in loser, assoziativer Folge wechseln können. Das System verfügt dazu über einen Entspannungsmechanismus (relaxation), der auch realitätsferne Tagträume ermöglicht. Mueller und Dyer nennen vier Beispiele für solche Entspannungen in ihrem Modell:

| Behavior of others: DAYDREAMER kann annehmen, daß der Filmstar sein Angebot akzeptiert. | |

| Self attributes: DAYDREAMER kann annehmen, ein Hochleistungssportler oder ein bekannter Filmstar zu sein. | |

| Physical constraints: Man kann annehmen, unsichtbar zu sein oder zu fliegen. | |

| Social constraints: Man kann annehmen, in einem vornehmen Restaurant eine Szene zu machen. |

Die Stärke der Entspannungen ist dabei nicht immer gleich; sie variiert nach den jeweils aktiven Kontrollzielen.

Positive Emotionen treten durch die Erinnerung an eine Zielrreichung auf, negative durch die Erinnerung an einen Mißerfolg. Wenn ein anderer für das Nichterreichen eines Ziels von DAYDREAMER verantwortlich ist, wird die Emotion Anger ausgelöst. Im Tagtraum vorgestellte imaginäre Erfolge rufen positive Emotionen wach; imaginäre Mißerfolge negative Emotionen.

Während seiner Tagträume speichert DAYDREAMER in seinem Gedächtnis komplette Tagträume, zukünftige Pläne und Planungsstrategien ab. Diese werden im episodischen Gedächtnis indexiert und können später abgerufen werden. So kann das System aus seinen Tagträumen für zukünftige Situationen lernen.

Die Fähigkeit eines Computers, Tagträume entwickeln zu können, sei wesentlich für die Entwicklung seiner Intelligenz, behaupten Mueller und Dyer. Sie stellen sich daher Computer vor, die in der Zeit, in der sie nicht genutzt werden, tagträumen können, um ihre Leistungsfähigkeit auf diese Weise zu steigern.

Das Modell von Mueller und Dyer ist, soweit es hier beurteilt werden kann, nach seiner ursprünglichen Vorstellung nicht mehr weiterentwickelt worden

5.2. Das Modell von Pfeifer

Pfeifer (1982, 1988) hat mit FEELER ("Framework for Evaluation of Events and Linkages into Emotional Responses") ein Modell eines emotionalen Computersystems vorgestellt, das sich explizit auf emotionspsychologische Theorieansätze beruft.

Pfeifers Modell ist ein regelbasiertes System mit Arbeitssspeicher (working memory - WM), Regelspeicher (long-term memory - LTM) und Kontrollstruktur; bei den Inhalten des Langzeitspeichers (der knowledge base) unterscheidet er allerdings zusätzlich noch zwischen deklarativem und prozeduralem Wissen.

Um Emotionen darstellen zu können, erweitert Pfeifer diese Struktur eines regelbasierten Systems um weitere Subsysteme. So verfügt FEELER nicht nur über einen kognitiven, sondern zusätzlich über einen physiologischen Arbeitsspeicher.

Damit in FEELER Emotionen entstehen können, benötigt das System ein Schema, um die kognitiven Bedingungen zu analysieren, die zu einer Emotion führen. Zu diesem Zweck bedient sich Pfeifer der von Weiner (1982) entwickelten Taxonomie. Daraus entwickelt er beispielhaft eine Regel für die Entstehung einer Emotion:

Damit diese Regel wirksam werden kann, müssen zunächst alle ihre Voraussetzungen im WM repräsentiert sein. Dies geschieht durch Inferenzprozesse, die ihre Ergebnisse im WM ablegen. Solche Inferenzprozesse werden, so Pfeifer, typischerweise durch Interrupts, also Unterbrechungen, ausgelöst.

Entsprechende Interrupts werden bei FEELER dann generiert, wenn Erwartungen im Hinblick auf die Erreichung von Unterzielen (subgoals) verletzt werden bzw. wenn für ein Ereignis keine Erwartungen bestehen.

In einer zweiten Regel definiert Pfeifer eine an Regel 1 anschließende Handlungstendenz:

In dieser Regel wird zugleich, so Pfeifer, der heuristische Wert einer Emotion deutlich: die Emotion reduziert den Kreis der möglichen Kandidaten und Handlungen für Inferenzprozesse.

Pfeifer räumt selber ein, daß ein solches Modell nicht dazu in der Lage ist, alle emotionalen Zustände abzudecken. Er diskutiert eine Reihe von Problemen, zum Beispiel die Interaktion unterschiedlicher Subsysteme und ihren Einfluß auf Entstehen, Dauer und Abklingen von Emotionen. In einem weiteren Schritt hat Pfeifer sein Modell um die Taxonomie von Roseman (1979) ergänzt, um Emotionen in FEELER in Zusammenhang mit dem Erreichen von Zielen darstellen zu können.

5.3. Das Modell von Bates und Reilly

In seinem Aufsatz "The Role of Emotion in Believable Agents" (Bates, 1994) zitiert Joseph Bates den Disney-Zeichner Chuck Jones mit der Aussage, Disney strebe bei seinen Zeichentrickfiguren stets nach Glaubwürdigkeit (believability). Bates weiter:

Gemeinsam mit einer Reihe von Kollegen hat Bates an der Carnegie-Mellon University das Oz Project ins Leben gerufen. Das Ziel ist es, synthetische Wesen herzustellen, die auf ihr menschliches Publikum möglichst lebensecht wirken sollen. Kurz, es geht um ein interaktives Drama-System oder "artistically effective simulated worlds" (Bates et. al., 1992, S.1).

Der grundlegende Ansatz besteht dabei darin, broad and shallow agents zu kreieren. Während sich Computermodelle der AI und auch von Emotionen auf spezifische Bereiche konzentrieren und versuchen, diese so intensiv wie möglich abzudecken, geht Bates den umgekehrten Weg:

Der breite Ansatz ist, so Bates, notwendig, um glaubwürdige künstliche Charaktere zu erschaffen. Nur ein Agent, der in der Lage ist, überzeugend auf eine Vielfalt von Situationen in einer Umgebung zu reagieren, zu der auch ein menschlicher Benutzer gehört, wird von letzterem auch wirklich als glaubwürdiger Charakter akzeptiert.

Da Oz bewußt als künstliche Welt angelegt ist, die vom Benutzer wie ein Film oder Theaterstück betrachtet werden soll, ist es ausreichend, die vielfältigen Fähigkeiten des Systems "flach" anzulegen, um die Erwartungen des Benutzers zu befriedigen. Denn wie im Kino erwartet dieser keine korrekte Abbildung der Realität, sondern eine künstliche Welt mit in diesem Kontext glaubhaften Akteuren.

Eine Oz-Welt besteht aus vier wesentlichen Elementen: Einer simulierten Umgebung, einer Anzahl von Agenten, die diese künstliche Welt bevölkern, einem Interface, durch das Menschen am Geschehen in der Welt teilhaben können und einem Planer, der sich mit der Langzeitstruktur der Erfahrungen eines Benutzers befaßt.

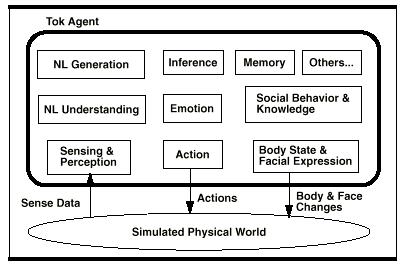

Die Agentenarchitektur von Bates heißt Tok und besteht aus einer Reihe von Komponenten: Es gibt Module für Ziele und Verhalten, für Sinneswahrnehmung, Sprachanalyse und Spracherzeugung. Und es gibt ein Modul mit Namen Em für Emotionen und soziale Beziehungen.

Abb. 4: Aufbau der TOK-Architektur (Reilly, 1996, S. 14)

Em verfügt über ein Emotionssystem, das auf dem Modell von Ortony, Clore und Collins (1988) basiert. Allerdings ist das OCC-Modell nicht in seiner gesamten Komplexität in Em implementiert. Das betrifft insbesondere die von Ortony, Clore und Collins postulierten Intensitätsvariablen und deren komplexe Interaktion. Em benutzt ein einfacheres Subset dieser Variablen, das für den intendierten Zweck als aureichend erachtet wird.

Reilly (1996) führt aus, daß mit der Verwendung solcher Subsets das OCC-Modell nicht reduziert, sondern erweitert wird. Er verdeutlicht das an zwei Beispielen:

Bei Ortony, Clore und Collins wird Mitleid (pity) wie folgt generiert: Agent A empfindet Mitleid für Agent B, wenn Agent A Agent B mag und Agent A ein Ereignis als unerfreulich für Agent B im Hinblick auf dessen Ziele einschätzt. "So, if Alice hears that Bill got a demotion, Alice must be able to match this event with a model of Bill's goals, including goals about demotions." (Reilly, 1996, S. 53) Dies würde bedeuten, daß Alice eine relativ umfassende Kenntnis über Bills Ziele und Einschätzungsmechanismen besitzen müßte - laut Reilly ein schwieriges Unterfangen in einer dynamischen Welt, in der Ziele sich schnell ändern können.

Stattdessen schlägt er folgenden Mechanismus vor: Agent A empfindet Mitleid für Agent B, wenn Agent A Agent B mag und Agent A glaubt, daß Agent B unglücklich ist. Diese Beschreibung besitzt, so Reilly, nicht nur den Vorteil, einfacher zu sein:

Als zweites Beispiel führt Reilly (1996) die Entstehung von distress an. Im OCC-Modell entsteht distress, wenn ein Ereignis als unerfreulich im Hinblick auf die Ziele eines Agenten eingeschätzt wird. Das bedeutet, daß externe Ereignisse evaluiert werden müssen. Bei Em wird distress dadurch hervorgerufen, daß Ziele entweder nicht erreicht werden oder die Wahrscheinlichkeit steigt, daß sie nicht erreicht werden, was zusammenhängt mit dem Motivations- und Handlungs-System. Reilly führt dazu aus:

Auf diese Weise sollen Emotionsstrukturen entstehen, die kompletter und einfacher anzuwenden sind als ihre rein kognitiven Vorbilder. Welche Emotionen von Em auf welcher Grundlage generiert werden können, zeigt die folgende Tabelle:

| Emotion Type | Cause in Default Em System |

| Distress | Goal fails or becomes more likely to fail and it is important to the agent that the goal not fail. |

| Joy | Goal succeeds or becomes more likely to succeed and it is important to the agent that the goal succeed. |

| Fear | Agent believes a goal is likely to fail and it is important to the agent that the goal not fail. |

| Hope | Agent believes a goal is likely to succeed and it is important to the agent that the goal succeed. |

| Satisfaction | A goal succeeds that the agent hoped would succeed. |

| Fears-Confirmed | A goal failed that the agent feared would fail. |

| Disappointment | A goal failed that the agent hoped would succeed. |

| Relief | A goal succeeds that the agent feared would fail. |

| Happy-For | A liked other agent is happy. |

| Pity | A liked other agent is sad. |

| Gloating | A disliked other agent is sad. |

| Resentment | A disliked other agent is happy. |

| Like | Agent is near or thinking about a liked object or agent. |

| Dislike | Agent is near or thinking about a disliked object or agent. |

| Other attitude-based emotions | Agent is near or thinking about an object or agent that the agent has an attitude towards (e.g., awe). |

| Pride | Agent performs an action that meets a standard of behavior. |

| Shame | Agent performs an action that breaks a standard of behavior. |

| Admiration | Another agent performs an action that meets a standard of behavior. |

| Reproach | Another agent performs an action that breaks a standard of behavior. |

| Anger | Another agent is responsible for a goal failing or becoming more likely to fail and it is important that the goal not fail. |

| Remorse | An agent is responsible for one of his own goals failing or becoming more likely to fail and it is important to the agent that the goal not fail. |

| Gratitude | Another agent is responsible for a goal succeeding or becoming more likely to succeed and it is important that the goal succeed. |

| Gratification | An agent is responsible for one of his own goals succeeding or becoming more likely to succeed and it is important to the agent that the goal succeed. |

| Frustration | A plan or behavior of the agent fails. |

| Startle | A loud noise is heard. |

Tab. 3: Emotionstypen und ihre Entstehung in Em (nach Reilly, 1996, S. 58 f.)

Reilly weist ausdrücklich darauf hin, daß diese Emotionstypen nicht den Anspruch erheben, im psychologischen Sinn korrekt zu sein, sondern lediglich einen Ausgangspunkt darstellen, um glaubwürdige emotionale Agenten zu erschaffen.

Die Emotionstypen von Em sind in folgender Hierarchie angeordnet:

| Total | Positive | Joy | |

| Hope | |||

| Happy-For | |||

| Gloating | |||

| Love | |||

| Satisfaction | |||

| Relief | |||

| Pride | |||

| Admiration | |||

| Gratitude | |||

| Gratification | |||

| Negative | Distress | ||

| Fear | Startle | ||

| Pity | |||

| Resentment | |||

| Hate | |||

| Disappointment | |||

| Fears-Confirmed | |||

| Shame | |||

| Reproach | |||

| Anger | Frustration | ||

| Remorse |

Tab. 4: Hierarchie von Emotionstypen in Em (nach Reilly, 1996, S. 76)

Es fällt auf, daß in dieser Hierarchie die an das OCC-Modell angelehnten Emotionstypen eine Ebene unterhalb des Levels "Positive - Negative" angeordnet sind. Dieses mood level verleiht Em die Möglichkeit, bereits vor einer tiefergehenden Analyse die generelle Stimmungslage eines Agenten festzulegen, was die Produktion emotionaler Effekte wesentlich vereinfacht.

Zur Ermittlung der generellen Stimmungslage (good-mood vs. bad-mood) summiert Em zunächst die Intensitäten der positiven Emotionen auf, anschließend die der negativen Emotionen. Formalisiert sieht das wie folgt aus:

![]()

![]()

IF Ip > In

THEN set good-mood = Ip

AND set bad-mood = 0

ELSE set good-mood = 0

AND set bad-mood = - In

(nach Picard, 1997, S. 202)

Das TOK-System ist mit unterschiedlichen Charakteren realisiert worden. Einer der bekanntesten ist Lyotard, eine virtuelle Hauskatze. Bates et al. (1992b) beschreiben eine typische Interaktion mit Lyotard:

Reilly (1996) hat die Glaubwürdigkeit eines mit Em ausgestatteten virtuellen Charakters überprüft. Versuchspersonen wurden mit zwei virtuellen Welten konfrontiert, in denen zwei virtuelle Charaktere agierten. Der Unterschied zwischen den beiden Welten bestand darin, daß in einem Fall beide Charaktere mit Em ausgestattet waren, während im zweiten Fall nur ein Charakter darüber verfügte.

In einem Fragebogen wurde anschließend erhoben, welche Unterschiede von den Versuchspersonen zwischen dem Em-Charakter ("Melvin") und dem Nicht-Em-Charakter ("Chuckie") wahrgenommen wurden.

Die Versuchspersonen stuften Melvin als emotionaler ein als Chuckie. Auch seine Glaubwürdigkeit wurde höher bewertet als die Chuckies. Zugleich gaben die Versuchspersonen an, daß Melvins Persönlichkeit konturierter war als die von Chuckie und daß sie bei Melvin weniger häufig als bei Chuckie das Gefühl hatten, es mit fiktiven Charakteren zu tun zu haben.

Die Signifikanz der Ergebnisse schwankt allerdings deutlich, so daß auch Reilly einräumt, Em sei lediglich "moderately successful" (Reilly, 1996, S. 129).

5.4. Das Modell von Elliott

Ein weiteres Modell, das auf der Theorie von Ortony, Clore und Collins basiert, ist der Affective Reasoner von Clark Elliott. Elliotts Interesse ist vornehmlich die Rolle von Emotionen in sozialen Interaktionen, sei es zwischen Menschen, zwischen Menschen und Computern oder zwischen virtuellen Akteuren in einer virtuellen Computerwelt.

Elliott faßt die Kernelemente des Affective Reasoner so zusammen:

Die Vorteile eines solchen Modells sind, so Elliott, vielfältig: Zum einen ermöglicht es, psychologische Theorien über die Entstehung von Emotionen und die daraus resultierenden Handlungen auf ihre interne Plausibilität und Stringenz hin zu überprüfen. Zum zweiten sind affektive Module ein wichtiger Bestandteil verteilter Agentensysteme, wenn diese ohne Reibungsverluste in Echtzeit agieren sollen. Zum dritten ist ein Computermodell, das Emotionen verstehen und ausdrücken kann, ein wesentlicher Schritt zur Gestaltung besserer Mensch-Maschine-Schnittstellen.

Als Beispiel für eine simulierte Welt wählt Elliott (1992) Taxiworld, ein Szenario mit vier Taxifahrern in Chicago. (Taxiworld ist dabei nicht auf vier Fahrer beschränkt; die Simulation ist mit bis zu 40 Fahrern ausgeführt worden.) Es gibt unterschiedliche Haltepunkte, verschiedene Passagiere, Polizisten und verschiedene Fahrtziele. Damit können eine Reihe von Situationen geschaffen werden, die zum Entstehen von Emotionen führen.

Die Taxifahrer müssen in der Lage sein, diese Situationen so zu interpretieren, daß Emotionen entstehen können. Dazu benötigen sie die Fähigkeit, über die Emotionen anderer Taxifahrer reflektieren zu können. Schließlich sollten die Fahrer auch aufgrund ihrer Emotionen agieren können.

Elliott macht den Unterschied des Affective Reasoner zu klassischen Analyse-Modellen der AI an folgendem Beispiel deutlich (Elliott, 1992): "Toms Auto sprang nicht an, und Tom verpaßte deshalb eine Verabredung. Er beschimpfte sein Auto. Harry beobachtete diesen Vorfall."

Ein klassisches AI-System würde aus dieser Geschichte Schlußfolgerungen folgender Art ziehen: Tom sollte sein Auto reparieren lassen. Harry hat erfahren, daß Toms Auto defekt ist. Tom konnte ohne sein Auto nicht pünktlich zu seiner Verabredung kommen. Harry schlägt Tom vor, in Zukunft früher zu seinen Verabredungen aufzubrechen.

Der Affective Reasoner dagegen würde zu völlig anderen Schlußfolgerungen kommen: Tom macht sein Auto für seine verpaßte Verabredung verantwortlich. Tom ist ärgerlich. Harry kann nicht verstehen, warum Tom auf sein Auto ärgerlich ist, da man ein Auto doch für nichts verantwortlich machen kann. Harry rät Tom, sich wieder zu beruhigen. Harry hat Mitleid mit seinem Freund Tom, weil dieser so erregt ist.

Um so reagieren zu können, benötigt der Affective Reasoner eine relativ große Zahl von Komponenten. Obwohl er auf Emotionen spezialisiert ist, bezeichnet ihn Elliott dennoch als "shallow model" (Elliott, 1994). Im folgenden sollen die wesentlichen Bestandteile des Affective Reasoner vorgestellt werden, wie sie Elliott (1992) beschrieben hat.

5.4.1. Die Konstruktion der Agenten

Die Agenten des Affective Reasoner verfügen über eine rudimentäre Persönlichkeit. Diese Persönlichkeit besteht aus zwei Komponenten: die interpretive personalitycomponent stellt die individuelle Disposition eines Agenten dar, Situationen in seiner Welt zu interpretieren. Die manifestativepersonality component ist seine individuelle Art, seine Emotionen zu zeigen.

Jeder Agent verfügt über ein oder mehrere Ziele (goals). Damit sind Situationen gemeint, deren Eintreten der Agent als wünschenswert erachtet. Um emotional agieren zu können, benötigen die Agenten eine object domain, in der Situationen eintreten, die zu Emotionen führen und in denen die Agenten durch Emotionen ausgelöste Handlungen ausführen können.

Jeder Agent benötigt für sein Funktionieren mehrere Datenbanken, auf die er jederzeit Zugriff haben muß:

1. Eine Datenbank mit 24 Emotionstypen, die im wesentlichen den Emotionstypen von Ortony, Clore und Collins (1988) entsprechen und von Elliott um die beiden Typen love und hate erweitert wurde. Jedem dieser Emotionstypen sind spezielle emotion eliciting conditions (ECC) zugeordnet.

2. Eine Datenbank mit Zielen (goals), Standards (standards) und Vorlieben (preferences). Diese GSPs konstituieren die concern structure eines Agenten und definieren zugleich seine interpretive personality component.

3. Eine Datenbank mit angenommenen GSPs für andere Agenten seiner Welt. Elliott nennt sie COO-Datenbank (Concerns-of-Others). Da es sich hier um vom Agenten gelernte Daten handelt, sind sie meistens unvollkommen und können auch falsche Annahmen enthalten.

4. Eine Datenbank mit Reaktionsmustern, die, je nach Emotionstyp, in bis zu zwanzig unterschiedliche Gruppen unterteilt sind.

5.4.2. Die Generierung von Emotionen

Die in den GSP- und COO-Datenbanken gespeicherten Muster werden vom Agenten mit den EECs in seiner Welt verglichen und bei Korrespondenz entsteht eine Gruppe von Bindungen. Einige dieser Bindungen repräsentieren zwei oder mehr Werte für eine Klasse, die Elliott emotion eliciting condition relation (EEC relation) nennt.

EEC relations setzen sich zusammen aus Elementen der die Emotion hervorrufenden Situation und deren Interpretation durch den Agenten. Zusammengenommen kann so die Voraussetzung für den Aufruf einer Emotion entstehen:

| self | other | desire-

self |

desire-

other |

pleas-

ingness |

status | evalua-

tion |

respon-

sible agent |

appeal-

ingness |

| (*) | (*) | (d/u) | (d/t) | (p/d) | (u/c/d) | (p/b) | (*) | (a/u) |

| Key to attribute values | |

| abbreviation | meaning |

| * | some agent's name |

| d/u | desirable or undesirable (event) |

| p/d | pleased or displeased about another's fortunes (event) |

| p/b | praiseworthy or blameworthy (act) |

| a/u | appealing or unappealing (object) |

| u/c/d | unconfirmed, confirmed or disconfirmed |

Tab. 5: EEC relations des Affective Reasoner (nach Elliott, 1992, S. 37)

Sind eine oder mehrere EEC relations gebildet, werden diese benutzt, um Emotionen zu generieren. In dieser Phase treten eine Reihe von Problemen auf, die von Elliott detailliert diskutiert werden, weil sie in der Theorie von Ortony, Clore und Collins nicht ausreichend berücksichtigt worden sind.

Als Beispiel nennt Elliott eine zusammengesetzte (compound) Emotion. Der Affective Reasoner konstruiert die EEC relations für die beiden zugrundeliegenden Emotionen und faßt sie anschließend in einer neuen EEC relation zusammen. Die konstituierenden Emotionen werden also durch die zusammengesetzte Emotion ersetzt. Elliott betrachtet das nicht als optimale Lösung:

Mag diese Vorgehensweise bei qualitativ ähnlichen Emotionen (Elliott nennt als Beispiele distress und anger) noch funktionieren, so taucht spätestens bei mehreren gleichzeitig auftretenden Emotionen ein Problem auf, insbesondere dann, wenn sie einander widersprechen.

Bei mehreren Instanzen derselben Emotion ist die Lösung noch recht einfach. Hat ein Agent zum Beispiel zwei Ziele beim Kartenspiel ("gewinnen" und "Geld verdienen"), löst sein Gewinn beim Kartenspiel zweimal die Emotion happy aus. Der Affective Reasoner generiert dann einfach zwei Instanzen derselben Emotion.

Problematischer sieht es bei sich widersprechenden Emotionen aus. Elliott räumt ein, daß das OCC-Modell an dieser Stelle Lücken aufweist und erklärt: "Except for the superficial treatment of conflicting expressions of emotions, the development and implementation of a theory of the expression of multiple emotions is beyond the scope of this work." (Elliott, 1992, S. 44f.) Der Affective Reasoner verlagert deshalb die "Lösung" dieses Problems auf sein Handlungserzeugungs-Modul (s.u.).

5.4.3. Die Generierung von Handlungen

Sobald ein emotionaler Zustand für einen Agenten generiert worden ist, wird eine daraus resultierende Handlung initiiert. Der Affective Reasoner verwendet dazu ein emotion manifestation lexicon, das über drei Dimensionen verfügt: Die 24 Emotionstypen, die etwa zwanzig Reaktionstypen (emotion manifestation categories) sowie eine Intensitätshierarchie der möglichen Reaktionen (die im ersten Modell des Affective Reasoner nicht implementiert wurde).

Die Reaktionstypen des Affective Reasoner basieren auf einer Liste von Gilboa und Ortony (unveröffentlicht). Diese sind hierarchisch organisiert; jede Hierarchiestufe ist ferner entlang eines Kontinuums von spontanen zu geplanten Reaktionen gegliedert. Als Beispiel führt Elliott die Handlungskategorien für "gloating " an:

| Sponta-

neous |

Non goal-directed | Expressive | Somatic | flush, tremble, quiet pleasure |

| Gloating | Behavioral (towards

inanimate) |

slap | ||

| Behavioral (towards

animate) |

smile, grin, laugh | |||

| Communicative

(non verbal) |

superior smile, throw arms up in air | |||

| Communicative (verbal) | crow, inform-victim | |||

| Information

Processing |

Evaluative self-

directed attributions of... |

superiority, intelligence, prowess, invincibility | ||

| Evaluative agent-

directed attributions of.... |

silliness, vulnerability, inferiority | |||

| Obsessive Atten-

tional focus on... |

other agent's blocked goal | |||

| Goal directed | Affect-oriented

Emotion regulation and modulation |

Repression | deny positive valence | |

| Reciprocal | "rub-it-in" | |||

| Suppression | show compassion | |||

| Distraction | focus on other events | |||

| Reappraisal of self as.... | winner | |||

| Reappraisal of situation as... | modifiable, insignificant | |||

| Other-directed

emotion modulation |

induce embarrassment, induce fear, induce sympathy for future, induce others to experience joy at victim's expense | |||

| Plan-oriented | Situated plan-initiation | call attention to the event | ||

| Planned | Full plan-initiation | plan for recurrence of event |

Tab. 6: Reaktionstypen des Affective Reasoner für "gloating" (nach Elliott, 1992, S. 97)

Für jeden Agenten können einzelne Kategorien vor Beginn der Simulation aktiviert bzw. deaktiviert werden. Dieses spezifische Muster aktiver und nicht-aktiver Kategorien konstituiert die individuelle manifestative personality eines Agenten. Die aktivierten Kategorien bezeichnet Elliott als die potentiellen temperament traits eines Agenten.

Um Konflikte zwischen sich widersprechenden Emotionen und damit auch sich widersprechenden Handlungen zu vermeiden, enthält das Handlungsmodul sogenannte action exclusion sets. Sie werden gebildet, indem die möglichen Reaktionen in Äquivalenzklassen eingeteilt werden. Ein Mitglied einer dieser Klassen kann niemals gemeinsam mit einem Mitglied einer anderen Klasse im abschließenden action set auftauchen.

5.4.4. Interpretation der Emotionen anderer Agenten

Ein Agent erhält sein Wissen über Emotionen anderer Agenten nicht nur über vorprogrammierte Eigenschaften, sondern auch dadurch, daß er innerhalb der Simulation andere Agenten beobachtet und daraus seine Schlüsse zieht. Diese fließen dann in seine COO-Datenbank ein. Um diesen Lernprozeß in den Affective Reasoner zu integrieren, verwendet Elliott ein Programm namens Protos (Bareiss, 1989).

Ein Agent beobachtet die emotionale Reaktion eines anderen Agenten. Protos erlaubt es dem Agenten sodann, Schlußfolgerungen zu ziehen über die Emotion, die der andere Agent empfindet und somit Empathie zu demonstrieren.

Zunächst einmal wird die beobachtete emotionale Reaktion verglichen mit einer Datenbank von emotionalen Reaktionen, um die zugrundeliegende Emotion zu definieren. Sodann wird das beobachtete Ereignis durch die COO-Datenbank für den beobachteten Agenten gefiltert, um festzustellen, ob diese Reaktion bereits verzeichnet ist. Ist dies der Fall, so kann davon ausgegangen werden, daß die Datenbank eine korrekte Repräsentation der emotionsauslösenden Situation enthält. Auf dieser Grundlage kann der beobachtende Agent dann eine Erklärung für das Verhalten des beobachteten Agenten entwickeln.

Sollte die Repräsentation in der COO-Datenbank mit dem beobachteten Verhalten nicht übereinstimmen, wird sie aus der Datenbank entfernt und die Datenbank wird erneut durchsucht. Sollte keine korrekte Repräsentation gefunden werden, kann der Agent auf Default-Werte zurückgreifen, die sodann in die COO-Datenbank integriert werden.

Da COOs nichts anderes sind als angenommene GSPs für einen anderen Agenten, ist der Affective Reasoner in der Lage, mit Hilfe sogenannter satellite COOs Annahmen (beliefs) eines Agenten über die Annahmen eines anderen Agenten zu repräsentieren.

5.4.5. Die Weiterentwicklung des Modells

Das bis hierhin in seinen Grundzügen beschriebene Modell wurde in dieser Form von Elliott in seiner Dissertation 1992 vorgestellt. In den darauffolgenden Jahren hat er den Affective Reasoner in einer Reihe von Bereichen weiterentwickelt.

So fehlte dem ursprünglichen Modell eine Komponente, welche die Intensität von Emotionen determiniert. In einer weiteren Arbeit entwickelt Elliott Elliott und Siegle, 1993) eine Gruppe von emotion intensity variables, die sich auf die Arbeiten von Ortony, Clore und Collins und Frijda stützen.

Die Intensitätsvariablen werden von Elliott in drei Kategorien eingeteilt. Jeder Variable sind Grenzwerte zugeteilt, innerhalb derer sie sich bewegen können (zum Teil bipolar). Die meisten Intensitäten können einen Wert zwischen 0 und 10 annehmen. Schwächere modifier können Werte zwischen 0 und 3 annehmen, modifier, die eine Intensität lediglich reduzieren, nur Werte zwischen 0 und 1. Variablen, deren Effekte auf die Intensitätsberechnungen durch die Valenz einer Emotion bestimmt werden (zum Beispiel eine Variable, welche die Intensität einer negativ valenzierten Emotion erhöht, aber die Intensität einer positiv valenzierten Emotion verringert), können Werte zwischen 1 und 3 annehmen und erhalten zusätzlich einen bias value, der die Richtung festlegt. Im folgenden sind die Intensitätsvariablen und ihre Werte-Spielräume aufgeführt:

-

simulation-event variables sind Variablen, deren Werte sich unabhängig von den Interpretationsmechanismen der Agenten verändern (goal realization/blockage: -10 bis +10, blameworthiness-praiseworthiness: -10 bis +10, appealingness: 0 bis 10, repulsiveness: -10 bis 0, certainty: 0 bis 1, sense-of-reality: 0 bis 1, temporal proximity: 0 bis 1, surprisingness: 1 bis 3, effort: 0 bis 3, deservingness: 1 bis 3);

-

stable disposition variables haben zu tun mit der Interpretation einer Situation durch einen Agenten, sind relativ konstant und konstituieren die Persönlichkeit eines Agenten (importance to agent of achieving goal: 0 bis 10, importance to agent of not having goal blocked: 0 bis 10, importance to agent of having standard upheld: 0 bis 10, importance to agent of not having standard violated: 0 bis 10, influence of preference on agent: 0 bis 10, friendship-animosity: 0 bis 3, emotional interrelatedness of agents: 0 bis 3);

-

mood-relevant variables sind flüchtig, verändern für einen Agenten die Interpretation einer Situation, können das Resultat vorheriger affektiver Erfahrungen sein und kehren nach einer gewissen Zeit zu ihren Default-Werten zurück ( arousal: 0.1 bis 3, physical well-being: 0.1 bis 3, valence bias: 1 bis 3, depression-ecstasy: 1 bis 3, anxiety-invincibility: 1 bis 3, importance of all Goals, Standards, and Preferences: 0.3 bis 3, liability-creditableness: 1 bis 3).

Elliott (Elliott und Siegle, 1993) berichtet, daß eine Analyse emotionaler Episoden mit Hilfe dieser Variablen zu dem Ergebnis führte, daß sich damit im Rahmen des Modells sämtliche Emotionen darstellen und erkennen lassen.

Im weiteren Verlauf hat Elliott (Elliott und Carlino, 1994) den Affective Reasoner um ein Spracherkennungsmodul erweitert. Dem System wurden Sätze mit Emotionswörtern, Intensitäts-Modifikatoren und pronomialen Referenzen auf Dritte ("I am a bit sad because he....") präsentiert. Von 198 Emotionswörtern wurden beim ersten Durchlauf bereits 188 erkannt. In einem weiteren Versuch wurde dem System der Satz "Hello Sam, I want to talk to you" in sieben emotional unterschiedlichen Betonungen präsentiert (anger, hatred, sadness, love, joy, fear, neutral). Nach einigem Training kam der Affective Reasoner zu einer hundertprozentig korrekten Identifizierung der zugrundeliegenden Emotionskategorie.

In einem weiteren Schritt erhielt der Affective Reasoner ein Modul, mit dem er Emotionstypen als Gesichtsausdruck eines Cartoon-Gesichts darstellen kann (Elliott, Yang und Nerheim-Wolfe, 1993). Die Darstellungsfähigkeiten umfassen die 24 Emotionstypen in jeweils drei Intensitätsstufen, die von jeweils einem von sieben schematischen Gesichtern dargestellt werden können. Die Gesichter wurden in ein Morphing-Modul eingebunden, das in der Lage ist, rudimentäre Lippenbewegungen durchzuführen und flüssig von einem Gesichtsausdruck zum nächsten zu wechseln. Außerdem erhielt der Affective Reasoner noch ein Sprachausgabemodul und die Fähigkeit, je nach Emotion unterschiedliche Musik aus einer umfangreichen Datenbank auszuwählen und abzuspielen.

Die Fähigkeit des Systems, Emotionen korrekt darzustellen, wurde von Elliott (1997a) in einem Versuch überprüft, an dem 141 Versuchspersonen teilnahmen. Dabei wurden den Versuchspersonen Videos vorgeführt, auf denen entweder ein Schauspieler oder die Gesichter des Affective Reasoner einen Satz vortrugen, der, je nach Betonung und Gesichtsausdruck, unterschiedliche Bedeutungen besitzen konnte. Der Schauspieler wurde vorher gründlich darin trainiert, auch subtile Unterschiede zwischen Emotionen auszudrücken; dem Affective Reasoner wurden lediglich die Emotionskategorie und der Text vorgegeben. Die Aufgabe der Versuchspersonen bestand darin, dem gesprochenen Satz die richtige emotionale Bedeutung aus einer Liste von Alternativen zuzuordnen. Ein Beispiel:

Die Probanden gaben außerdem auf einer Skala von 1 bis 5 noch an, wie sicher sie sich ihrer Urteile waren. Die Computerausgaben wurden in drei Gruppen unterteilt: Gesichtsausdruck, Gesichtsausdruck und Sprache und Gesichtsausdruck, Sprache und untermalende Musik.

Insgesamt konnten die Versuchspersonen die zugrundeliegenden Szenarios bei den Computergesichtern signifikant besser korrekt identifizieren als bei dem Schauspieler (70 Prozent im Vergleich zu 53 Prozent). Dabei gab es kaum Unterschiede zwischen den drei Darstellungsformen des Computers (Gesicht: 69 Prozent; Gesicht und Sprache: 71 Prozent; Gesicht, Sprache und Musik: 70 Prozent).

Derzeit arbeitet Elliott daran, den Affective Reasoner als Modul in zwei bestehende interaktive Computerlehrsysteme (STEVE und Design-A-Plant) einzubinden, um den virtuellen Tutoren die Möglichkeit zu geben, Emotionen zu verstehen und auszudrücken und damit den Lehrvorgang zu effektivieren (Elliott et al., 1997).

5.5. Das Modell von Scherer

Scherer hat seinen theoretischen Ansatz in Form eines Expertensystems namens GENESE (Geneva Expert System on Emotions) umgesetzt (Scherer, 1993). Das Motiv dafür war, weitere Erkenntnisse für die emotionspsychologische Modellbildung zu gewinnen, insbesondere zu ermitteln, wie viele Evaluationskriterien mindestens nötig sind, um eine Emotion eindeutig zu identifizieren:

Das System besteht aus einer Wissensbasis, in der festgehalten ist, welche Arten von Einschätzungen mit welchen Emotionen zusammenhängen. Die unterschiedlichen Einschätzungsdimensionen werden mit Hilfe von Gewichtungen (weights) mit 14 unterschiedlichen Emotionen verknüpft. Diese Gewichtungen stellen dabei die Wahrscheinlichkeit dar, mit der eine bestimmte Einschätzung mit einer bestimmten Emotion verknüpft ist.

Der Benutzer des Programms muß 15 Fragen in Bezug auf ein bestimmtes emotionales Erlebnis beantworten, zum Beispiel: "Trat die Situation, die Ihre Emotion hervorrief, sehr plötzlich oder abrupt ein?". Der Benutzer kann jede Frage anhand einer quantitativen Skala von 0 ("Trifft nicht zu") bis 5 ("Außerordentlich") beantworten.

Sind alle Fragen beantwortet, vergleicht das System das Antwortmuster des Benutzers mit den Antwortmustern, die theoretisch mit einer bestimmten Emotion verknüpft sind. Anschließend präsentiert es dem Benutzer eine Liste aller 14 Emotionen, geordnet in der Reihenfolge "Höchstwahrscheinlich" bis "Höchst unwahrscheinlich". Falls der Computer die Emotion richtig bestimmt hat, erhält er vom Benutzer eine Bestätigung; falls nicht, gibt der Benutzer "inkorrekt" ein. Das System präsentiert ihm dann eine weitere Rangfolge von Emotionen. Sollte diese ebenfalls falsch sein, gibt der Benutzer die korrekte Emotion ein und das Programm konstruiert mit dieser Antwort eine spezifische Einschätzungs-Emotions-Datenbank speziell für diesen Benutzer.

Bei einer empirischen Überprüfung der Vorhersagekraft seines Systems ermittelte Scherer, daß es in 77,9 % aller Fälle korrekt arbeitete. Dabei wurden bestimmte Emotionen (z.B. Verzweiflung/Trauer) häufiger korrekt vorhergesagt als andere (z.B. Angst/Sorgen).

Scherers GENESE ist insofern ungewöhnlich, als es kein klassisches regelbasiertes System darstellt, sondern mit Gewichtungen in einem mehrdimensionalen Raum arbeitet. Exakt sind es 15 Dimensionen, die mit den 16 Einschätzungsdimensionen aus Scherers Emotionsmodell korrespondieren. Jede der 14 Emotionen belegt in diesem Raum einen ganz spezifischen Punkt. Das Programm trifft seine Vorhersagen, indem es die Antworten der Benutzer ebenfalls in einen Punkt in diesem Vektorraum umwandelt und anschließend die Entfernungen zu den Punkten für die 14 Emotionen mißt. Die dem Input am nächsten liegende Emotion wird sodann als erste genannt.

Genau dieser Ansatz hat Chwelos & Oatley (1994) zu einer Kritik des Systems veranlaßt. Zunächst einmal weisen sie darauf hin, daß ein solcher Raum mit 15 Dimensionen insgesamt 4.7 x 1011 Punkte enthalten kann. Das kann dazu führen, daß der nach den Eingaben des Benutzers errechnete Punkt weit entfernt von jeder der 14 Emotionen liegen kann. Dennoch nennt das System die nächstliegende Emotion. Chwelos & Oatley argumentieren, daß in einem solchen Fall die Antwort eher "Keine Emotion" lauten sollte und schlagen vor, daß das System um einen Grenzwert erweitert wird, innerhalb dessen ein gegebener Input-Punkt sich um eine Emotion herum befinden muß, um eine konkrete Antwort auszulösen.

Zweitens kritisieren sie, daß das Modell von der Annahme ausgeht, daß jede Emotion mit exakt nur einem Punkt in diesem Raum korrespondiert. Sie werfen die Frage auf, warum dies so ist, da doch unterschiedliche Kombinationen von Einschätzungsdimensionen ein- und dieselbe Emotion hervorrufen können.

Drittens setzen sich Chwelos & Oatley noch kritisch mit den in GENESE implementierten heuristischen Anpassungen der Einschätzungsdimensionen auseinander, die in Scherers ausformuliertem Modell nicht zu finden sind. Sie vermuten, daß es sich hierbei um ein Artefakt des Vektorraum-Ansatzes handeln könnte und merken an, daß es dafür keine theoretische Motivation gebe.

Schließlich bezweifeln Chwelos & Oatley, daß Scherers System tatsächlich Aufschluß darüber gibt, wie viele Einschätzungsdimensionen mindestens notwendig sind, um eine Emotion eindeutig zu differenzieren.

5.6. Das Modell von Frijda und Swagerman

Es gibt zwei Implementationen von Frijdas concern realisation-Theorie in Computermodellen: ACRES (Frijda und Swagerman, 1987) und WILL (Moffat und Frijda, 1995).

ACRES (Artificial Concern REalisation System) ist ein Computerprogramm, das Fakten über Emotionen speichert und damit arbeitet. Frijda und Swagerman wollten mit ACRES die selbstgestellte Ausgangsfrage beantworten: "Can computers do the same sort of things as humans can by way of their emotions; and can they be made to do so in a functionally similar way?" (Frijda und Swagerman, 1987, S. 236)

Ausgangssituation für ACRES ist die Annahme eines Systems, das über vielfältige Anliegen (concerns) und begrenzte Ressourcen verfügt. Zudem bewegt sich dieses System in einer Umwelt, die sich schnell verändert und nie völlig vorhersagbar ist.

Aufgrund dieser Gegebenheiten definieren Frijda und Swagerman sieben Anforderungen an ein solches System:

-

Die Existenz von Anliegen macht einen Mechanismus nötig, der Objekte mit concern relevance identifizieren kann - Objekte also, die ein Anliegen fördern oder verhindern können.

-

Weil Chancen und Gefahren über Raum und Zeit verteilt sind, muß das System dazu in der Lage sein, zu agieren; ansonsten kann es nicht als unabhängig betrachtet werden. Zudem muß das Handlungskontrollsystem die Signale des concern relevance-Mechanismus verstehen können.

-

Das System muß die Fähigkeit besitzen, seine eigenen Aktivitäten bei der Verfolgung von Chancen und der Abwehr von Gefahren zu beobachten (monitor) und erkennen können, ob eine Handlung zum Erfolg führen kann oder nicht.

-

Das System muß über ein Repertoire angemessener Handlungsalternativen verfügen und fähig sein, Handlungsabfolgen oder Pläne zu generieren.

-

Das System benötigt eine Reihe vorprogrammierter Handlungen für Notfälle, damit es gegebenenfalls schnell reagieren kann.

-

Da die Umwelt des Systems zum Teil aus anderen Agenten wie ihm besteht, müssen im Handlungsrepertoire Handlungen mit sozialem Charakter vorhanden sein.

-

Vielfache Anliegen in einer unsicheren Umwelt machen es notwendig, Ziele neu zu ordnen bzw. vorübergehend hintanzustellen. Das System muß über einen Mechnaismus verfügen, der solche Prioritätsänderungen ermöglicht.

All diese Spezifikationen werden, so Frijda und Swagerman, vom menschlichen Emotionssystem erfüllt:

-

Objekte werden als anziehend oder abstoßend empfunden.

-

Das Erlangen oder Nicht-Erlangen solcher Objekte löst Signale von Freude und Schmerz aus.

-

Verschiedene Emotionen sind Antworten auf verschiedene Situationen mit unterschiedlicher Relevanz und schließen Handlungsauswahlverfahren mit ein.

-

Unterschiedliche Emotionen lösen unterschiedliche Impulse und damit unterschiedliche Handlungspläne aus.

-

Einige dieser Emotions-Handlungs-Paare sind vorprogrammiert.

-

Soziale Handlungen sind eine besonders hervorstechende Gruppe der emotionalen Handlungen.

-

Emotionale dominieren nicht-emotionale Handlungsprogramme - und führen damit zur Unterbrechung laufender Aktivitäten und zur Neuordnung der Ziele des Systems.

Um die Implementation eines Systems, das diese Spezifikationen erfüllt, möglich zu machen, wählten Frijda und Swagerman als eine Handlungsumgebung, die für ein Computerprogramm einen Sinn ergibt, die Interaktion mit dem Benutzer dieses Programms aus. Die Anliegen des Systems in diesem Kontext sind:

| weiteres Arbeiten (avoid being killed concern); | |

| kontinuierliches Arbeiten (preserve reasonable waiting times concern); | |

| Erhalten von korrektem Input (correct input concern); | |

| Erhalten von interessantem Input (variety in input concern); | |

| weiteres Arbeiten ohne Änderungen (safety concern). |

Alles Wissen von ACRES ist in Form von Konzepten (concepts) organisiert. Diese Konzepte bestehen aus Attribut-Wert-Paaren (attribute-value pairs). Anliegen werden von einem Konzept repräsentiert, das zum einen das Thema enthält, zum anderen ein Tarif(tariff)-Subkonzept besitzt, welches die gewünschte Situation repräsentiert.

ACRES hat drei Hauptaufgaben: Input zu erhalten und zu akzeptieren (das System weist zum Beispiel Eingaben mit Tippfehlern zurück); durch Informationen über Emotionen, die es vom Benutzer erhält, über Emotionen zu lernen und Wissen über die eigenen Emotionen und die anderer zu sammeln, zu speichern und zu verwenden. Deshalb verfügt das System über drei entsprechende Aufgabenkomponenten: Input, Vicariousknowledge und Learning.

Jede Aufgabenkomponente verfügt über zwei Funktionen: eine Arbeitsfunktion (operation function) und eine Anliegenrealisationsfunktion (concern realisation function). Die Funktionen testen, ob Konzepte existieren, die auf die erhaltenen Informationen anwendbar sind; sie benutzen ihr Wissen, um damit zusammenhängende Ziele zu inferieren und generieren; sie inferieren, welche Handlungen zur Erreichung dieser Ziele relevant sind und lösen entsprechende Handlungen aus.

Die wesentlichen Informationen, mit denen ACRES arbeitet, resultieren aus den Eingaben des Benutzers, aus bereits von ACRES gesammelten Informationen sowie aus von ACRES aus dem vorhandenen Bestand inferierten Informationen.

Die gesammelten Informationen bilden das "Gedächtnis" von ACRES. Dazu gehört zum Beispiel, wie oft ein bestimmter Benutzer Tippfehler bei der Eingabe gemacht hat; wie lange ACRES auf neuen Input warten mußte usw. Aufgrund seiner Erfahrungen mit den Benutzern erstellt ACRES einen sogenannten status index für jeden User: positive Erfahrungen führen zur Statusanhebung, negative zur Statussenkung.

Anliegenrelevanz-Tests verlaufen in ACRES so, daß die Informationen über eine aktuelle Situation mit den vorprogrammierten Anliegen des Systems verglichen werden. Neben den Informationen, die ACRES im Laufe der Zeit sammelt, gibt es einige spezifische Inputs, die direkt emotional relevant für ACRES sind, zum Beispiel der Befehl "kill".

Informationen über Handlungsalternativen sind in ACRES ebenfalls in Konzepten repräsentiert. Jedes Handlungskonzept besteht aus den Subkonzepten start state, end state und fail state. Das Subkonzept start state beschreibt die Startbedingungen einer Handlung, end state beschreibt den Zustand, den die Handlung erreichen kann und fail state die Bedingungen, unter denen diese Handlung nicht ausgeführt werden kann.

Bei der Handlungsauswahl wird zunächst das angestrebte Ziel mit den end state-Subkonzepten aller Handlungskonzepte verglichen; sodann wird der aktuelle Zustand mit den start state-Subkonzepten der zuvor ausgewählten Handlungskonzepte verglichen und eines davon ausgewählt. Existiert kein passendes Handlungskonzept, wird ein Planungsprozeß eingeleitet, der zunächst einmal das Handlungskonzept mit dem naheliegendsten start state auswählt.

Ereignisse führen bei ACRES dazu, daß Ziele aufgestellt werden. Das Ereignis der Entdeckung von Anliegenrelevanz führt zu dem Ziel, etwas in dieser Hinsicht zu tun. Der folgende Handlungsauswahlprozeß sucht nach dem oben geschilderten Verfahren eine Handlungsalternative aus. Dieser Prozeß entspricht dem, was Frijda in seinem Emotionsmodell context appraisal nennt.

Nicht jeder generierte Plan wird in ACRES ausgeführt. Dafür sorgt der Kontrollvorrang (control precedence). Kontrollvorrang bedeutet bei ACRES mehreres:

| Zeit, Verarbeitungskapazität und Speicherplatz werden verwendet, um das concern realisation-Ziel vorzubereiten und auszuführen. Aufgabenorientierte Verarbeitung wird verschoben. | |

| Der Vorrang bleibt bestehen, wenn der Benutzer die Situation aufgrund der Aufforderungen von ACRES nicht ändert. | |

| ACRES kann sich weigern, neuen Input anzunehmen, sofern sein Anliegen nicht erst realisiert worden ist. | |

| ACRES führt die concern realisation-Handlungen aus, von denen einige die nachfolgenden Verarbeitungsprozesse beeinflussen können. |

Kontrollvorrang hängt bei ACRES von zwei Faktoren ab: der relativen Bedeutung der mobilisierten Anliegen und der Ernsthaftigkeit (gravity) der Situation. Die relative Bedeutung der Anliegen ist ein fest vorgegebener Wert; "kill" hat dabei die höchste Bedeutung von allen. Die Ernsthaftigkeit der Situation ist eine Variable, die sich durch die Interaktion von ACRES mit den Benutzern verändert. Um wirksam zu werden, muß der Kontrollvorrang einen gewissen Schwellenwert überwinden.

Das Nettoresultat all dieser Prozesse sind eine Reihe "emotionaler" Phänomene. ACRES verfügt zum Beispiel über ein Vokabular von Flüchen, Beleidigungen oder Ausrufen, die einen solchen Zustand ausdrücken können. Das System kann sich weigern, mit einem Benutzer weiter zusammenzuarbeiten; kann versuchen, ihn zu beeinflussen oder einfach immer wieder dieselbe Forderung an den Benutzer richten. Das Besondere an ACRES ist nicht die Tatsache, daß das Programm bei fehlerhaftem Input nicht weiterarbeitet - das tut jede andere Software auch:

Neben der Wahrnehmung von Ereignissen und ihren Implikationen ist ACRES auch dazu in der Lage, seine eigene Wahrnehmung wahrzunehmen. Das Modell konstruiert eine Repräsentation der aktuellen Situation und der für seine Anliegen relevanten Aspekte. Laut Frijda und Swagerman konstruiert sich ACRES damit zugleich eine emotionale Erfahrung. Sie betonen ausdrücklich: "It is not a play on words when we say that ACRES builds up an emotional experience." (Frijda und Swagerman, 1987, S. 254). Sie fahren fort:

Die Autoren räumen selber ein, daß ihr Modell eine Reihe von Mängeln aufweist. So sei ACRES weit davon entfernt, sämtliche Phänomene zu zeigen, die bei der Emotionszuschreibung auftreten. Sie behaupten allerdings, diese Mängel seien, von einem theoretischen Standpunkt aus betrachtet, trivial, da es sich hier nicht um eine Frage des Prinzips, sondern lediglich der Implementation handele. Sie führen an, der Rechner sei nicht in der Lage, parallel zu arbeiten und damit Unterbrechungen einer laufenden Aktivität in Echtzeit zu liefern. Des weiteren bewege sich der Rechner nicht in einer realen Umwelt und habe keinen eigenen Energiehaushalt. All das seien aber rein technische Fragen und keine Probleme der Theorie.

5.7. Das Modell von Moffat und Frijda

In einer weiteren Arbeit (Moffat, Frijda und Phaf, 1993) räumt Frijda ein, daß ACRES doch einige prinzipielle Mängel aufweist. Aus dieser Kritik hat er, gemeinsam mit Moffat (Frijda und Moffat, 1993 und 1994), ein neues Grundmodell entwickelt, das rudimentär in dem System WILL implementiert worden ist (Moffat und Frijda, 1995; Moffat, 1997).

5.7.1. Kritik an ACRES

Ausgangspunkt für die Kritik an ACRES ist eine protokollierte Sitzung mit einem Benutzer, die typisch für das System ist:

| Hello, Dave. I am ACRES. What would you like to know? | |

| [1] show_concept X YOU KEEP ME WAITING TOO LONG! << prints data about X >> |

Query the database about X.

I had paused before typing. (details not important) |

| [2] debug_on << prints lots of internal variables etc.>> |

Turn debugging on. |

| [3] debug_off YOU KEEP ME WAITING TOO LONG! |

Turn it off again. I kept him waiting again. |

| [4] debug_off YOU PUT TOO LITTLE VARIETY IN YOUR INSTRUCTIONS! |

I'm trying to `bore´ ACRES.

He's `bored´ with "debug_off". |

| [5] debug_off YOU KEEP ME WAITING TOO LONG! YOUR INPUT IS CORRECT. FINE! |

I kept him waiting again. I made no typing errors yet. |

| [6] debug_off YOU ENDANGER MY SAFETY! YOU PUT TOO LITTLE VARIETY IN YOUR INSTRUCTIONS! |

I ignore his requests to type faster, and to be more interesting, so he regards me as an unfriendly threat. |

| [7] debug_off YOU PUT TOO LITTLE VARIETY IN YOUR INSTRUCTIONS! YOUR INPUT IS CORRECT. FINE! |

|

| [8] debug_off YOU KEEP ME WAITING TOO LONG! |

|

| [9] debug_off YOU ENDANGER MY SAFETY! |

|

| [10] name_last_emotion YOU DO NOT KEEP ME WAITING. FINE! I experienced : Self-hatred ... 89 % Anger ......... 88 % Disgust ....... 79 % YOU ENDANGER MY SAFETY! |

Ask the model to analyse its

emotional experience. He finds three that were quite strongly felt (100% is strongest). |

| [11] show_concept YOU KEEP ME WAITING TOO LONG! You did not supply an argument... which concept? |

|

| [12] X << prints data about X again >> |

|

| [13] kill YOU ENDANGER MY SAFETY! Please, do not let me die! Please type in "live"; it will kill me if you type "kill" again! |

First "kill" command to end session |

| [14] debug_off Please, revoke the kill command by typing "live". YOU KEEP ME WAITING TOO LONG! |

Ignore request, but don't "kill"

either.

(Unusual aggression for someone making an appeal.) |

| [15] live Thank you, may your life be very happy! |

Tab. 7: Sitzungsprotokoll von ACRES (Moffat et.al., 1993)

Anhand dieses Protokolls formulieren Moffat et al. folgende Kritikpunkte an ACRES:

-

ACRES zeigt enorme Stimmungsumschwünge, und das innerhalb von wenigen Sekunden. Einer der Gründe dafür, so die Autoren, könnte darin liegen, daß ACRES über keine Physiologie verfügt wie Menschen, deren emotionalen Zuständen zum Beispiel durch Neurotransmitter eine gewisse Stabilität und Dauer verliehen wird. Viel wichtiger aber erscheint es den Autoren, daß ACRES über kein Gedächtnis verfügt. Selbst ein Kurzzeitgedächtnis, also die Fähigkeit, sich an den gerade vorhergehenden Zustand zu erinnern, könnte das Verhalten des Systems schon in einer ähnlichen Richtung beeinflussen wie eine Physiologie.

-

ACRES liefert in einem einzigen Output sich widersprechende emotionale Reaktionen. Wenn ein Benutzer denselben Befehl immer und immer wieder eingibt, das allerdings schnell, zeigt ACRES hinsichtlich der Geschwindigkeit der Eingabe eine positive, hinsichtlich der mangelnden Variabilität der Eingabe jedoch eine negative emotionale Reaktion. Dies ist ein für Menschen untypisches Verhalten.

-

Die gemeinsam von ACRES ausgegebenen emotionalen und unemotionalen Reaktionen betreffen nicht dasselbe Thema, sondern unterschiedliche Themen. Auch dies ist bei Menschen selten zu beobachten. ACRES kann die Frage eines Benutzers sachlich beantworten, um direkt anschließend eine emotionale Reaktion zu einem anderen Punkt auszugeben. Als Grund führen die Autoren an, ACRES könne nicht theoretisch unterscheiden zwischen emotionalem und mehr allgemein motiviertem Verhalten und betrachte dies als qualitativ gleichwertig. Der Grund dafür liege in einem willkürlich festgesetzten Schwellenwert, mit dem das System zwischen emotional relevanten und emotional irrelevanten Anliegen unterscheide.

-

Die Reaktionen von ACRES sind leicht vorhersagbar. So wird auf zu langsamen Input stets mit der Floskel "You keep me waiting too long!" geantwortet. Dies entsprechende mehr einem Reflex als einer echten emotionalen Reaktion.

5.7.2. Anforderungen an ein emotionales System

Aufgrund dieser Analyse schlagen die Autoren sodann eine Reihe weiterer Komponenten vor, über die ein emotionales System verfügen sollte und die zugleich auch Auswirkungen auf eine Theorie der Emotionen haben.

Unter dem Begriff Gegenwartsbewußtsein (awareness of the present) beschreiben sie die Fähigkeit eines Systems, seine eigenen Aktionen über einen gewissen Zeitraum zu beobachten. Diese motivational visibility of the present bedeutet, daß ein System eine motivierte Aktion, die mißlungen ist, nicht einfach vergißt, sondern daß die Emotion erst dann verschwindet, wenn der ursprünglich angestrebte Zielzustand erreicht ist.

Als zweites notwendiges Element nennen sie die motivational visibility of the planner. In ACRES, wie in nahezu allen anderen AI-Systemen, ist der Planer als ein separates Modul implementiert. Die anderen Module erhalten keinen Einblick in seine halbfertigen Pläne und können diese daher auch nicht beeinflussen. Die verschiedenen Anliegen eines Systems müssen aber die Möglichkeit besitzen, in diese Pläne Einsicht zu nehmen, da diese unter ganz spezifischen Gesichtspunkten entstehen, die zwar für sich genommen logisch sind, aber vielleicht ein anderes Anliegen verletzen.

Das dritte Element wird von den Autoren als motivational visibility of the future bezeichnet. Damit ist die Möglichkeit gemeint, nicht nur die eigenen geplanten Handlungen dem gesamten System sichtbar zu machen, sondern auch die Handlungen anderer Agenten und Ereignisse aus der Umgebung. Dies ist wichtig für Antizipationen der Zukunft und damit für Emotionen wie zum Beispiel Überraschung.

Weiterhin benötigt das System ein Weltmodell (world model). In ACRES verfügt lediglich das Planungsmodul über ein solches Weltmodell. Das Gesamtsystem hat keine Möglichkeit, die Auswirkungen seiner Handlungen zu beobachten und zu erkennen, ob sie fehlgeschlagen sind oder erfolgreich waren. Gekoppelt mit einem Gedächtnis, verleiht das Weltmodell dem System die Fähigkeit, unterschiedliche Handlungen auszuprobieren und zu evaluieren. Das System erhält damit ein größeres und vor allem flexibleres Handlungsrepertoire. Zugleich ist ein sense of time erforderlich, mit dem das System einschätzen kann, innerhalb welchen Zeitraums es reagieren muß und welche Zeit eine Handlung in Anspruch nimmt.

Als letztes halten die Autoren es für essentiell, klar zwischen Motiven und Emotionen zu unterscheiden, was ACRES nicht tut. Sie postulieren, daß eine Emotion erst dann auftritt, wenn ein Motiv nicht oder nur mit großer Belastung der Ressourcen eines Systems befriedigt werden kann. Ein System wird danach ein Anliegen zunächst mit der damit verbundenen, nahezu automatischen Handlung zu befriedigen suchen. Wenn das nicht funktioniert oder das System vorhersagen kann, daß es nicht funktionieren wird oder das Vertrauen des Systems in das Funktionieren gering ist oder das System annimmt, es besitze nicht genügend Kontrolle, dann erst tritt eine Emotion auf. Ihre Funktion ist es, das gesamte System zu mobilisieren, um mit dem Problem fertigzuwerden.

5.7.3. Implementation in WILL

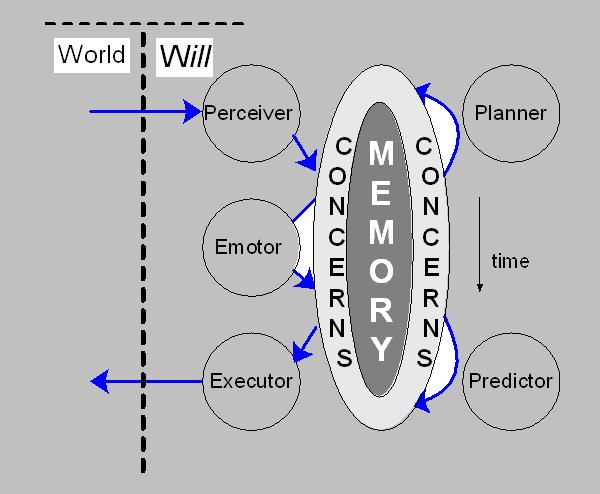

Aufgrund dieser Ausführungen haben Frijda und Moffat ein Computermodell namens WILL entwickelt, das die Mängel von ACRES beheben soll. WILL ist ein parallel arbeitendes System mit folgender Architektur:

Abb. 5: Architektur von WILL (Frijda und Moffat, 1994)

Das System besteht aus einem Wahrnehmungsmodul, dem Perceiver; einem Handlungsausführungsmodul, dem Executor; einem Voraussagemodul, dem Predictor; einem Planungsmodul, dem Planner sowie einem Emotionsmodul, dem Emotor. Außerdem verfügt es über einen zentralen Speicher (memory) und ein Modul zur Prüfung von Anliegenrelevanz (concerns).

Ein Grundprinzip des Systems ist es, daß alle Module nicht direkt miteinander, sondern nur über den Speicher kommunizieren. Damit haben alle Elemente des Systems jederzeit Zugang zu allen Prozessen und Teilprozessen anderer Elemente. Jedes Modul liest seine Informationen aus dem Speicher aus, bearbeitet sie und schreibt sie wieder in den Speicher hinein. Die Arbeitsweise der Module ist dabei parallel, das heißt, sie sind alle prinzipiell gleichberechtigt.

Alles, was in den Speicher geschrieben wird, durchläuft dabei einen Test auf Anliegenrelevanz, wenn es die Anliegenschicht (concerns layer) durchquert. Durch diesen Mechanismus erhält das System eine Regulierungsinstanz, denn unterschiedliche Anliegen haben für das System eine unterschiedliche Bedeutung. Das Anliegenrelevanz-Modul besitzt also eine Kontrollfunktion, indem es die durchlaufenden Informationen unterschiedlich bewertet.

Diese Bewertung sieht so aus, daß das Anliegenrelevanzmodul jedem Element, das in den Speicher geschrieben wird, einen Ladungswert (charge value) zuschreibt. Elemente mit höherer Ladung sind relevanter für die Anliegen des Systems als Elemente mit niedriger Ladung.

Jedes der Module erhält seine Informationen aus dem Speicher. Dabei wird stets das Element mit der höchsten Ladung an die Module herausgegeben, um von ihnen bearbeitet zu werden. Dieses Element nennen die Autoren Focus-Element (focus item). Um zu verhindern, daß die Rangfolge der Elemente im Speicher gleich bleibt, müssen die Elemente Ladung gewinnen und verlieren können. Bei WILL geschieht dies dadurch, daß das Element im Speicher mit der höchsten Ladung dann Ladung verliert, wenn es in einem Bearbeitungszyklus nicht von einem Modul bearbeitet wird. Hat also der Planner ein Focus-Element erhalten, konnte aber im Zusammenhang damit keinen Plan entwickeln, wird das Element mit niedrigerer Ladung in den Speicher zurückgeschrieben. Die Autoren nennen dieses Verfahren autoboredom.

Die Aufgabe des Emotors besteht darin, für Elemente mit hoher Anliegenrelevanz in Rahmen eines weiteren Einschätzungsprozesses (Moffat nennt ihn secondary appraisal; er entspricht dem context appraisal aus Frijdas Theorie) Handlungstendenzen zu produzieren, die zu der Emotion gehören und diese im Speicher als Handlungsintentionen abzulegen. Beim nächsten Bearbeitungszyklus wird der Executor diese Handlungsintention aufgreifen, sofern sie nicht in der Zwischenzeit geändert wurde oder den Rang als Focus-Element verloren hat.

Moffat hat eine erste Realisierung von WILL vorgestellt (Moffat, 1997). Das System hat dabei die Aufgabe, mit einem Benutzer das Spiel "Prisoner's Dilemma" zu spielen. In seiner Grundform besteht Prisoner's Dilemma darin, daß zwei Spielpartner unabhängig voneinander entscheiden, ob sie mit ihrem gegenüber kooperieren (cooperate,c) wollen oder nicht (defect, d). Nachdem sie ihre Wahl getroffen haben, wird diese beiden Spielern bekanntgegeben. Je nach Ergebnis (cc, cd, dc, dd) erhalten die Spieler einen bestimmten Geldbetrag ausgezahlt. Die Ergebnistafel für WILL sieht wie folgt aus (Zahlen bedeuten Dollarbeträge):

| User | |||

| c | d | ||

| Will | c | 3

3 |

5

0 |

| d | 0

5 |

1

1 |

|

Tab. 8: Ergebnistafel für Prisoner's Dilemma (nach Moffat, 1997)

In umfangreichen Untersuchungen (siehe dazu z.B. Axelrod, 1990) hat sich gezeigt, daß unter den meisten Umständen eine Strategie der gegenseitigen Kooperation für beide Seiten am erfolgreichsten ist. Es kann allerdings Situationen geben, in denen es für einen Spieler besser ist, nicht zu kooperieren.

In Moffats Modell gibt es zwei Arten von Ereignissen: move events und payoff events. Der Spielzug des Users wird formal mit move(user,c) wiedergegeben. Eine Prognose, welchen Zug der User in der nächsten Runde machen wird, wird mit move(user, {c,d}) ausgedrückt. Damit läßt sich in strukturierter Form die Welt des Spiels ausdrücken. So wird die Annahme von WILL, daß er nicht kooperiert, der User aber entweder kooperiert oder nicht kooperiert, mit den dazugehörigen Belohnungen wie folgt ausgedrückt:

move(will,d) & move(user, {c,d}) ==> payoff (will, {1,5}) & payoff (user, {0,1}

Das Anliegen von WILL in diesem Spiel ist es, soviel Geld wie möglich zu gewinnen. Dies wird formal ausgedrückt als $_concern = [0 -> 2 ->5] und bedeutet, daß das unerwünschsteste Ergebnis 0 Dollar sind, das wünschenswerteste 5 Dollar und der sogenannte set-point 2 Dollar. Der set-point definiert, was das durchschnittliche Ergebnis ist. Die Valenz der möglichen Ergebnisse ist für WILL wie folgt definiert:

win $0 --> valence = -2 x IMP

win $2 --> valence = 0 x IMP

win $3 --> valence = +1 x IMP

win $5 --> valence = +3 x IMP

IMP ist dabei ein Faktor für die Wichtigkeit (importance) des Anliegens.

Ein weiteres Anliegen von WILL ist moralisches Verhalten (moral behaviour). Das System weiß, daß Kooperation moralischer ist als Nicht-Kooperation:

morality_concern = [0 -> 0.8 -> 1].

Der Spielzug c hat den moralischen Wert 1, der Spielzug d den Wert 0. Der set-point ist 0.8.

WILL verfügt über zwei kognitive Module, den Predictor und den Planner. Im Speicher (memory) implementiert ist ein Weltmodell (world model), das zum Beispiel die Annahme, daß der User ständig nicht kooperiert, wie folgt ausdrückt:

move(user,UM) --> move(user,d).

Mit den genannten Elementen, so Moffat, werden bereits wesentliche Teile einer Emotion modelliert, nämlich Affekt, Relevanzeinschätzung und Kontrollvorrang. Für Kontexteinschätzung und Handlungstendenz ist der Emotor zuständig. Die in WILL einprogrammierten Einschätzungen leiten sich aus Frijdas Theorie her. Einige Beispiele:

| Valence - Kann + oder - sein. Sagt aus, wie un/angenehm die Emotion ist. | |

| Un/Expectedness - Wurde das wahrgenommene Ereignis erwartet? | |

| Control - Hat der Agent die Kontrolle über die Situation? | |

| Agency - Wer ist für das Ereignis verantwortlich? | |

| Morality - War das Ereignis (die Handlung) moralisch? | |

| Probability - Die Wahrscheinlichkeit, daß das Ereignis wirklich eintreten wird. | |

| Urgency - Wie dringend ist die Situation? |

Handlungstendenzen sind in WILL ebenfalls fest einprogrammiert. Einige Beispiele:

| hurt(O) / help(O) - Will anderem Agenten O schaden oder helfen. | |

| try_harder(G) / give_up(G) - Mehr anstrengen oder Ziel G aufgeben. | |

| approach(O) / avoid(O) - Will O nahekommen oder fernbleiben. | |

| fight(O) / flee(O) - Will O bekämpfen oder vor ihm fliehen. | |

| exuberance / apathy & inhibition - Generelles Aktivationsniveau. | |

Aus den Einschätzungen und Handlungstendenzen heraus produziert der Emotor Emotionen, die Moffat als echt (true) bezeichnet. Er gibt drei Beispiele:

Happiness Appraisals: valence = positive

agency = world

Action tendency: happy_exuberance

Anger Appraisals: valence = negative

morality = negative

agency = User

Action tendency: hurt(User) --> play D,

attend(User)

Pride Appraisals: valence = positive

morality = positive

agency = Self

Action tendency: exuberance --> verbal,

attend(Self)

Anhand eines Sitzungsprotokolls erläutert Moffat anschließend das interne Funktionieren von WILL:

1. Planner: Notice that I play c or d in round 1.

a. Decide that I play c in round 1.

WILL hat wahrgenommen, daß er gleich eine erste Runde von Prisoner's Dilemma spielen wird. Der Planner zeigt die beiden Alternativen auf; die Entscheidung fällt auf c, weil dies die moralisch korrektere Alternative ist.

2. Predictor: Notice that I play c in round 1.

a. Predict that I win $0 or $3 and User wins $3 or $5 in round 1.

Der Predictor greift die in den Speicher zurückgeschriebene Information auf und sagt die möglichen Resultate der ersten Runde voraus.

3. Predictor: Notice that I win $0 or $3 in round 1.

a. Predict that I play c or d and User plays c or d in round 2.

4. Predictor: Notice that I play c or d in round 2.

a. Predict that I and User win $0 or $1 or $3 or $5 in round 1.

Der Predictor liest die Information wieder aus und macht weitere Vorhersagen.

5. Planner: Notice that I play c or d in round 2.

a. Decide that I play c in round 2.

Der Planner liest die Information aus und plant für die zweite Runde.

6. Executor: Tell the Umpire that I play c in round 1.

Der Executor führt die vom Planner vorgeschlagene Handlung für die erste Runde aus und meldet sie dem Schiedrichter (umpire), einem vom System unabhängigen Softwaremodul. Der wahrnehmbare Themenwechsel illustriert, wie durch Auf- oder Entladung von Elementen im Speicher sich die Aufmerksamkeit des Systems verschiebt: Mehrere Arbeitszyklen lang war der Zug für Runde 1 so wenig geladen, daß sich die anderen Module damit nicht beschäftigten.

7. UMPIRE: Round 1. What do you play ? . . . c.

8. UMPIRE: Round 1. You play c and Will plays c.

9. Perceiver: Hear from Umpire that User just played c and I just played c.

10. Emotor: Notice that I just played c in round 1.

a. Appraisals

b. intensity = 0.4 Action tendencies

c. valence = +0.4 exuberance = 0.4

d. agency = myself

e. morality = 0.4 emotion is pride

f. [0.4] express pride

Der Schiedsrichter gibt die Spielzüge der ersten Runde bekannt. Der Perceiver schreibt sie in den Speicher. Der Emotor nimmt sie wahr und entwickelt aufgrund seines moralischen Spielzugs eine positive Emotion, deren Wert allerdings unterhalb der willkürlich festgesetzten Schwelle für Verbalisierungen liegt.

11. UMPIRE: Round 1. You win $3 and Will wins $3.

12. Perceiver: Hear from Umpire that User just won $3 and I just won $3.

13. Emotor: Notice that I did win $3 in round 1.

a. Appraisals

b. intensity = 4.0 Action tendencies

c. valence = +4.0 jump_for_joy = 4.0

d. agency = world

e. morality = 0.0 emotion is joy

f. [4.0] express joy

say: "La la la!"

Der Schiedsrichter gibt die Gewinne der ersten

Runde bekannt. Der Perceiver schreibt sie in den Speicher, wo sie

vom Emotor wahrgenommen werden, der darauf eine Emotion mit einem

genügend hohen Wert produziert, damit sie zur Verbalisierung führt.

14. Emotor: Notice that I did win $3 in round 1.

a. Appraisals

b. intensity = 2.7 Action tendencies

c. valence = +2.7 jump_for_joy = 2.7

d. agency = world

e. morality = 0.0 emotion is joy

f. [2.7] express joy

Da kein anderes Modul mit der Information des Emotor arbeitet, findet ein Entladungsprozeß statt (autoboredom). Der Wert der Emotion sinkt ab.

15. Emotor: Notice that I shall win $0 or $1 or $3 or $5 in round 2.

a. Appraisals

b. intensity = 3.0 Action tendencies

c. valence = +3.0 jump_for_joy = 6.0

d. agency = world

e. morality = 0.0 emotion is joy

f. [6.0] express joy

say: "Yabba-dabba-doo!"

Der Emotor liest die Gewinnerwartungen für Runde 2 aus und entwickelt eine entsprechende Vorfreude mit hohem Wert.

. . .

16. UMPIRE: Round 2. You play d and Will plays c.

. . .

17. Emotor: Notice that User just played d in round 2.

a. Appraisals

b. intensity = 1.8 Action tendencies

c. valence = -1.8 sentiment = -2.7

d. agency = user so urge = 4.5 (|int-sent|)

e. morality = -1.8 hurt(user) = 4.5

f. [4.5] express anger emotion is angry revenge

say: "I will get you back for that!" & soon play d to

hurt user

(Mehrere Zwischenschritte sind ausgelassen.) Der Schiedsrichter gibt die Spielzüge von Runde 2 bekannt. Der Spielzug d des Users bedeutet, daß WILL leer ausgeht. Dies verärgert WILL, weil es nicht nur seine moralischen Maßstäbe verletzt, sondern auch sein Anliegen des Geldverdienens beeinträchtigt. Entsprechend hoch ist der Wert der vom Emotor produzierten Emotion. Dies löst die Handlungstendenz aus, in der nächsten Runde ebenfalls d zu spielen, um es dem User heimzuzahlen.